تنبيه: تم ترجمة هذا المقال بواسطة Falcon-Arabic 🦅

نحن متحمسون للإعلان عن Falcon-Arabic، نموذج لغوي كبير يحتوي على 7 مليار معامل ويعد معيارًا جديدًا لمعالجة اللغة العربية طبيعيًا. مبني على بنية Falcon 3 المتعددة اللغات، يدعم Falcon-Arabic اللغة العربية واللغة الإنجليزية وعدد من اللغات الأخرى. يتفوق في المعرفة العامة والقواعد النحوية العربية والاستدلال الرياضي وحل المشاكل المعقدة وفهم تنوع اللهجات العربية.

يدعم Falcon-Arabic طول سياق بمقدار 32 ألف رمز (token)، مما يمكنه من التعامل مع الوثائق الطويلة، وتمكين تطبيقات متقدمة مثل توليد المحتوى المدعوم بالاسترجاع (RAG)، وإنشاء محتوى عميق، والمهام المعرفية.

يقوم Falcon-Arabic بإعادة تعريف حدود ما يمكن تحقيقه فيما يتعلق بالنماذج اللغوية العربية. فهو يفوق بكثير النماذج الأخرى ذات الحجم المماثل وحتى تلك الأكبر بأربعة أضعاف، سواء كانت نماذج عربية الأصل أو نماذج تم تكييفها من لغات أخرى. وهذا يجعل Falcon-Arabic ليس فقط نموذجاً رائداً من حيث الأداء، بل أيضاً حلاً فريداً وفعالاً ومتاحاً للباحثين والمطورين المهتمين باللغة العربية.

🚀 نقدم Falcon-Arabic: نحو تطوير نماذج لغوية كبيرة للعالم الناطق بالعربية

في السنوات الأخيرة، قامت النماذج اللغوية الكبيرة بإحداث قفزة نوعية في الذكاء الاصطناعي، وتمكنت من توفير أدوات للترجمة وإنشاء المحتوى والمساعدة الافتراضية وغيرها الكثير. ولكن معظم هذا التقدم ركز على لغات معينة مثل الإنجليزية، تاركاً لغات اخرى، مثل العربية، دون تمثيل كافٍ. تشكل اللغة العربية تحديات فريدة فهي غنية بالنحو، ثنائية اللهجة (تشمل كلاً من اللغة العربية المعاصرة واللهجات المحلية المتنوعة)، وتستخدم من قبل سكان متنوعين ثقافيا. إن تطوير نماذج اللغة العربية متقدمة المستوى يعد أمراً ضرورياً لضمان حصول المجتمعات الناطقة بالعربية على المزايا التي نشهدها مع ثورة الذكاء الاصطناعي.

بناءً على هذه الرؤية، نعلن لكم عن Falcon-Arabic، نسخة متخصصة من عائلة نماذج Falcon 3، المطورة من قبل معهد الابتكار التكنولوجي (TII) في دولة الإمارات العربية المتحدة. اكتسبت عائلة Falcon شهرة عالمية بفضل قدرتها القوية على التعامل مع اللغات المتعددة ونهجها المفتوح المصدر. يبني Falcon-Arabic على هذا الإرث، حيث يجلب قدرات متقدمة في فهم اللغة العربية وتوليدها. ومن خلال تدريب النموذج للتعامل مع اللغة العربية المعاصرة وبعض اللهجات المحورية، يملأ Falcon-Arabic فجوة حرجة في تكنولوجيا اللغة، مما يمكّن ذكاءً عربيًا أكثر طبيعية وذكيًا وشاملًا عبر الخليج والشرق الأوسط وشمال أفريقيا.

🦅 Falcon-Arabic قد حطّ رحاله - إليكم وصفة التدريب 🧪

بدأ بناء Falcon-Arabic بقرار استراتيجي: بدلاً من تدريب نموذج من الصفر، اخترنا تكييف أساس متعدد اللغات قوي. وفي مشهد نماذج اللغة العربية، هناك ثلاث طرق رئيسية: التدريب من الصفر (على سبيل المثال، Jais-native)، تكييف النماذج متعددة اللغات (مثل Allam أو Fanar)، أو استخدام نماذج تدعم اللغة العربية ضمن مجموعة من اللغات الأخرى (مثل Qwen أو LLaMA). عند النظر إلى لوحة صدارة النماذج العربية المفتوحة، أصبح من الواضح أن النماذج المتكيفة والمتعددة اللغات تفوقت باستمرار على غيرها من حيث الكفاءة والقدرة. للاستفادة من هذا الزخم، قمنا باختيار Falcon 3-7B، وهو نموذج يحقق توازن عملي بين الأداء وكفاءة الموارد ضمن عائلة Falcon 3 المطورة من قبل معهد الابتكار التكنولوجي (TII).

كان التحدي الأساسي هو تكييف Falcon 3-7B، الذي يفتقر أصلاً لدعم اللغة العربية على مستوى المحلل الصرفي (tokenizer) أو التمثيلات الأولية (embeddings). لقد عالجنا ذلك بإضافة “32,000 رمز عربي محدد” إلى قاموس المحلل اللغوي، وتطبيق استراتيجية جديدة لتهيئة التمثيلات الأولية مبنية على تشابه النصوص. تعمل هذه التقنية على تعيين الرموز العربية الجديدة إلى تمثيلات مشابهة معنويًا من المفردات الأصلية، مما يسمح للنموذج باكتساب المعرفة السابقة وتسريع التعلم خاصة حول المشاعر والمفاهيم المجردة وأنماط الاستدلال. أعطى هذا Falcon-Arabic بداية جيدة لفهم وإنتاج نص عالي الجودة باللغة العربية.

مع تجهيز المحلل الصرفي والتمثيلات الأولية، بدأنا بتدريب مستمر باستخدام مجموعات بيانات عالية الجودة بنسبة 100٪ أصلية باللغة العربية، وتجنبنا استخدام المحتوى المترجم آلياً لتقليل الانحياز الثقافي وحفظ الأصالة اللغوية. اتبع التدريب منهجاً متعدد المراحل: ركزت المراحل المبكرة على “المعرفة العامة ومحتوى غني باللهجة العربية” لتثبيت النموذج وتعزيز القدرات المنطقية، بينما ركزت المراحل اللاحقة على “الرياضيات والبرمجة والاستدلال”. كانت النتيجة نموذج يتحدث العربية بطلاقة و بلهجات عديدة ويحتفظ بقوة Falcon متعددة اللغات وقدرات الاستدلال، دافعًا حدود الذكاء الاصطناعي باللغة العربية.

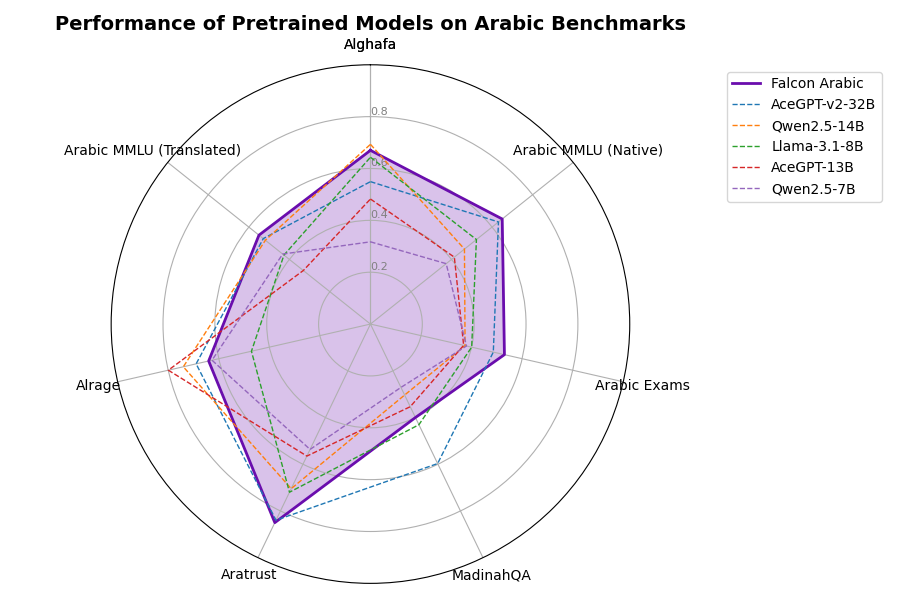

متوسط أداء النماذج المسبقة التدريب

📊 Falcon-Arabic: الارتقاء بمعايير النماذج اللغوية العربية الكبيرة

قمنا بتقييم Falcon-Arabic على OALL v2، وهو المعيار الرائد لتقييم النماذج اللغوية العربية. يتضمن هذا المعيار ست مهام من نوع الاختيار من متعدد مثل Arabic MMLU (بالنسختين الأصلية والمترجمة)، وArabic Exams، وAlghafa، وMadinahQA، وAratrust، بالإضافة إلى معيار توليدي واحد هو Alrage. يتفوق Falcon-Arabic على جميع النماذج العربية الموجودة ضمن نفس الفئة الحجمية، بل ويتجاوز أداء نماذج أكبر منه حتى بأربع مرات. وقد تصدّر نتائج معايير رئيسية مثل Arabic MMLU، وExams، وMadinahQA، وAratrust، مما يضع معيارًا جديدًا للنماذج اللغوية المصممة خصيصًا للغة العربية.

جدول مقارنة النماذج المسبقة التدريب

| Model | Average | ALGhafa | ArabicMMLU | Exams | MadinahQA | AraTrust | ALRAGE | ArbMMLU-HT |

|---|---|---|---|---|---|---|---|---|

| AceGPT-v2-32B | 61.74 | 54.93 | 63.15 | 48.6 | 59.71 | 83.96 | 68.96 | 52.87 |

| Qwen2.5-14B | 54.26 | 69.32 | 46.37 | 37.43 | 30.38 | 70.46 | 74.03 | 51.84 |

| AceGPT-13B | 47.21 | 48.23 | 41.38 | 36.87 | 35.37 | 56.51 | 79.96 | 32.12 |

| Llama-3.1-8B | 51.64 | 64.34 | 52.28 | 40.04 | 43.08 | 71.98 | 47.08 | 42.67 |

| Qwen2.5-7B | 41.97 | 31.72 | 37.36 | 37.99 | 27.11 | 53.66 | 62.68 | 43.30 |

| Falcon-Arabic-7B-Base | 62.57 | 67.17 | 64.85 | 52.89 | 48.79 | 85.36 | 63.71 | 55.25 |

تفاصيل التقييم (log probabilities، التنبؤات ومعايير LLM كحكم) لـ Falcon-Arabic-7B-Base متاحة على https://huggingface.co/datasets/tiiuae/Falcon-Arabic-7B-Base-details

🗣️ من التدريب الأولي إلى الدردشة: تدريب Falcon-Arabic على المحادثات

بعد الانتهاء من مرحلة تدريب النموذج الأساسي، أجرينا مرحلة “التوافق بعد التدريب” لضبط ردود Falcon-Arabic وفقًا لتفضيلات البشر. بدأت هذه المرحلة بمرحلة “الصقل الخاضعة للإشراف” (SFT) باستخدام مزيج من مجموعات بيانات عامة عالية الجودة وبيانات داخلية مجمعة “باللغة العربية الأصلية”، تغطي مجموعة واسعة من المهام وسيناريوهات المحادثة.

لتعزيز التوافق بشكل أكبر، طبقنا طريقة “تحسين التفضيل المباشر” (DPO)، وهي طريقة تعلم معززة تقوم بضبط النموذج ليفضل الردود التي يصنفها البشر بأنها أكثر فائدة وأمانًا وملاءمة. تضمن هذه العملية المكونة من خطوتين أن يكون Falcon-Arabic Instruct يفهم اللغة العربية جيدًا و أن يرد بطريقة تتوافق مع توقعات المستخدم الحقيقية.

متوسط أداء نماذج المحادثة

كما تظهر نتائج الرسوم البيانية، فإن Falcon-Arabic Instruct يتصدر المجموعة، متفوق على جميع نماذج اللغة العربية الأخرى في فئته وحجمه وأكبر منه بشكل ملحوظ عبر عدة معايير. يُظهر النموذج أداءً قوياً في اتباع الإرشادات والحوار المفتوح، واضعًا معيارًا جديدًا للذكاء الاصطناعي الحواري باللغة العربية.

أداء نماذج المحادثة عبر معايير التقييم

جدول مقارنة نماذج المحادثة

| Model | Average | ALGhafa | ALRAGE | AraTrust | ArabicMMLU | ArbMMLU-HT | Exams | MadinahQA |

|---|---|---|---|---|---|---|---|---|

| aya-expanse-32b | 67.17 | 77.61 | 79.64 | 89.00 | 60.63 | 58.86 | 51.02 | 53.45 |

| c4ai-command-r7b-arabic-02-2025 | 67.07 | 74.84 | 75.90 | 80.47 | 59.34 | 50.14 | 64.99 | 63.84 |

| ALLaM-7B-Instruct-preview | 65.25 | 69.49 | 76.81 | 86.93 | 64.90 | 52.81 | 51.58 | 54.24 |

| Yehia-7B-preview | 65.68 | 70.81 | 76.64 | 87.49 | 64.90 | 53.40 | 52.14 | 54.37 |

| Qwen2-7B-Instruct | 63.61 | 73.24 | 71.13 | 82.77 | 60.01 | 51.30 | 47.30 | 59.50 |

| Falcon-Arabic-7B-Instruct | 68.03 | 72.40 | 71.77 | 82.54 | 68.23 | 55.37 | 53.25 | 72.95 |

تفاصيل التقييم (log probabilities، التنبؤات ومعايير LLM كحكم) لـ Falcon-Arabic-7B-Instruct متاحة على https://huggingface.co/datasets/tiiuae/Falcon-Arabic-7B-Instruct-details

🔓 إطلاق العنان لإمكانات الذكاء الاصطناعي العربي

يتحدى Falcon-Arabic المعايير فيما يتعلق بنماذج اللغة العربية. رغم أنه 7 مليار معامل، فإنه يقدم أداءً قياسياً يتفوق على النماذج المماثلة في الحجم وحتى تلك الأكبر بعدة مرات عبر مؤشرات أساسية مثل Arabic MMLU، MadinahQA، وAratrust. يجمع بين الطلاقة في اللغة العربية القياسية الحديثة والفهم القوي للهجات الإقليمية والقدرات الاستنباطية والمتعددة اللغات، مما يجعله مثاليًا لمجموعة واسعة من التطبيقات: بدءًا من روبوتات المحادثة التي تركز على اللغة العربية والأدوات التعليمية، والأدوات التعليمية، إلى توليد المحتوى، والمساعدة في البرمجة، وفهم المستندات.

لإعطائك فكرة عملية عما يمكن أن يفعله Falcon-Arabic ، قمنا ببناء عرض بسيط يُظهر قدراته في “الترجمة” رغم أن النموذج لم يتم ضبطه خصيصًا لهذا الغرض. تعمل الأداة بالكامل باستخدام “Falcon-7B-Arabic-Instruct”، والنتائج ممتازة عبر مختلف اتجاهات الترجمة. يمكنك تجربتها بنفسك من خلال العرض التجريبي المُشار إليه أدناه. لقد استخدمنا نفس الإعداد لترجمة هذا المنشور بالمدونة إلى اللغة العربية للجمهور الناطق بها 🚀. وإذا كنت ترغب في استكشاف المزيد ، فإننا نوفر أيضًا منصة تمكنك من التفاعل مع Falcon-Arabic Instruct وتجربة أدائه عبر مهام مختلفة ✨.

⚠️ القيود

مثل جميع النماذج اللغوية الضخمة، يرث Falcon-Arabic بعض القيود الشائعة. وتشمل هذه أحيانًا “الهلوسات” (إنتاج ردود معقولة ولكنها خاطئة)، وحساسية كيفية صياغة المطالبات، وأداء متغير عبر سياقات طويلة جداً. وعلى الرغم من تصميم Falcon-Arabic لتخفيف هذه القضايا خصوصًا للمهام المتعلقة باللغة العربية، يجب على المستخدمين ممارسة تفكير نقدي عند تفسير النتائج، وخاصة في الحالات الحساسة للأداء العالي أو الحساسة للحقائق.

الاستشهاد

إذا وجدت هذا العمل مفيدًا لبحثك أو مشاريعك، يرجى إضافة الاقتباس عنه.

@misc{falcon-arabic,

title = {Falcon-Arabic: A Breakthrough in Arabic Language Models},

author = {Falcon-LLM Team},

month = {May},

url = {https://falcon-lm.github.io/blog/falcon-arabic},

year = {2025}

}

Core Contributors

Basma El Amel Boussaha

Mohammed Alyafeai

Ahmed Alzubaidi

Leen AlQadi

Younes Belkada

Mikhail Lubinets

Hakim Hacid